Innovative Tech(AI+):

このコーナーでは、2014年から先端テクノロジーの研究を論文単位で記事にしているWebメディア「Seamless」(シームレス)を主宰する山下裕毅氏が執筆。新規性の高い科学論文を山下氏がピックアップし、解説する。

X: @shiropen2

米Appleに所属する研究者らが発表した論文「Ferret-UI: Grounded Mobile UI Understanding with Multimodal LLMs」は、iPhoneやAndroidなどのモバイルUI画面をより深く理解し、インタラクションできるように設計されたマルチモーダル大規模言語モデル(MLLM)を提案した研究報告である。

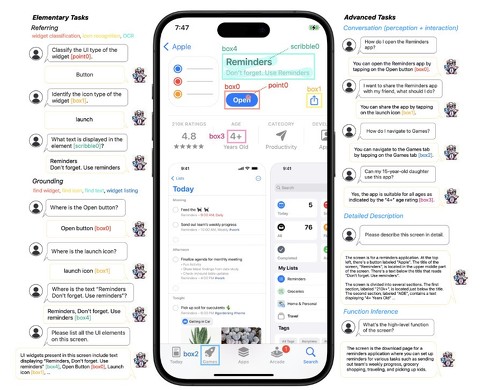

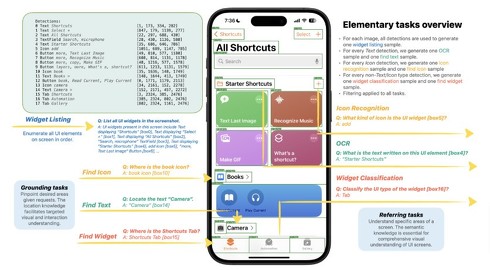

Ferret-UIは、モバイルUIの画面上で、多様な入力形式(点、ボックス、スケッチ)を用いて参照タスク(ウィジェット分類、アイコン認識、OCRなど)を実行し、グラウンディングタスク(ウィジェット検索、アイコン検索、テキスト検索、ウィジェットリスティングなど)を行える。またスクリーンショットの詳細な説明、質疑応答の対話、スクリーンの全体的な機能や目的を推測するタスクなども行える。

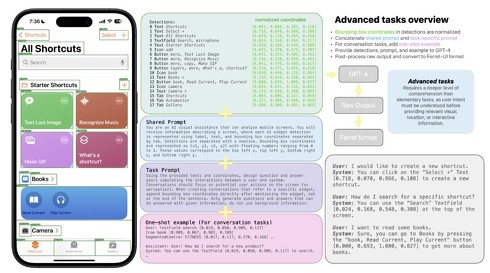

Ferret-UIは、同社が2023年10月に発表した画像内の形や場所を言葉で説明するAI「Ferret」をベースに開発。しかし、UIの画面は一般的に自然画像よりも細長いアスペクト比を持ち、アイコンやテキストなどの小さなオブジェクトが多数存在するという特徴がある。そのため、画面全体を低解像度のまま入力するだけでは、重要な視覚情報が失われてしまう恐れがあった。

この問題を解決するために、Ferret-UIでは「any-resolution」(anyres)技術を導入。この技術により、画面を複数のサブ画像に分割し、それぞれを別々にエンコードすることで、ディテールを拡大し、豊かな視覚的特徴を活用できるようになった。

学習には、基本的なUIタスクと高度なUIタスクのデータを生成する。基本的なUIタスクには、アイコン認識やテキスト検出などがあり、これらはモデルにUIエレメントのセマンティクスと空間的な位置関係を理解させるために重要である。

一方、高度なタスクには、詳細な説明や対話、機能推論などがあり、これらはモデルが視覚的な要素について議論し、目的に沿った行動を提案し、画面の全体的な機能を解釈できるように用意されている。

Ferret-UIの能力を評価するために、研究者らは参照タスクとグラウンディングタスクに関する14種類のモバイルUIタスクからなる包括的なテストベンチマークを開発した。

このベンチマークを用いてiPhoneとAndroidで評価した結果、Ferret-UIは他のオープンソースのMLLMやGPT-4Vと比較して、基本的なUIタスクにおいて大幅に優れたパフォーマンスを示すことが明らかに。さらに、高度なタスクにおいても、FuyuやCogAgentといった既存のモデルを上回る性能を発揮した。

Source and Image Credits: Keen You, Haotian Zhang, Eldon Schoop, Floris Weers, Amanda Swearngin, Jeffrey Nichols, Yinfei Yang, Zhe Gan. Ferret-UI: Grounded Mobile UI Understanding with Multimodal LLMs.

関連記事

関連リンク

https://news.google.com/rss/articles/CBMiPmh0dHBzOi8vd3d3Lml0bWVkaWEuY28uanAvYWlwbHVzL2FydGljbGVzLzI0MDQvMTIvbmV3czA0MC5odG1s0gEA?oc=5

2024-04-12 03:00:00Z

CBMiPmh0dHBzOi8vd3d3Lml0bWVkaWEuY28uanAvYWlwbHVzL2FydGljbGVzLzI0MDQvMTIvbmV3czA0MC5odG1s0gEA

Tidak ada komentar:

Posting Komentar